12/08/2018, 17:13

HADOOP - CÀI ĐẶT HADOOP TRÊN UBUNTU (PHẦN 2)

Tôi viết tiếp theo phần 1 ở đây 3. Cấu hình các tập tin XML Hadoop Tất cả các file cấu hình hadoop nằm trong thư mục /usr/local/hadoop/hadoop-2.7.0/etc/hadoop Đầu tiên, thực hiện lệnh dưới đây: cd /usr/local/hadoop/hadoop-2.7.0/etc/hadoop Cấu hình tập tin core-site.xml: Mở tập ...

Tôi viết tiếp theo phần 1 ở đây

3. Cấu hình các tập tin XML Hadoop

Tất cả các file cấu hình hadoop nằm trong thư mục /usr/local/hadoop/hadoop-2.7.0/etc/hadoop

Đầu tiên, thực hiện lệnh dưới đây:

cd /usr/local/hadoop/hadoop-2.7.0/etc/hadoop

-

Cấu hình tập tin core-site.xml:

Mở tập tin core-site.xml:

nano core-site.xml

Thêm các dòng dưới đây:

<configuration> <property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> </property> </configuration> -

Cấu hình tập tin mapred-site.xml:

Mở tập tin mapred-site.xml:

cp /usr/local/hadoop/hadoop-2.7.0/etc/hadoop/mapred-site.xml.template /usr/local/hadoop/hadoop-2.7.0/etc/hadoop/mapred-site.xml nano mapred-site.xml

Thêm các dòng dưới đây:

<configuration> <property> <name>mapred.job.tracker</name> <value>localhost:9001</value> </property> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> -

Cấu hình tập tin yarn.site.xml:

Mở tập tin yarn.site.xml:

nano yarn.site.xml

Thêm các dòng dưới đây:

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce-shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.shuffleHandler</value> </property> </configuration>

4. Tạo thư mục và phân quyền namenode và datanode.

Các file HDFS-site.xml được sử dụng để xác định các thư mục namenode và datanode.

Trong đó:

-

Namenode:

- NameNode còn được gọi là Master.

- NameNode chỉ chứa siêu dữ liệu của HDFS - cây thư mục của tất cả các tệp trong hệ thống tệp và theo dõi các tệp trên toàn bộ cụm.

- NameNode không lưu trữ dữ liệu thực tế hoặc tập dữ liệu. Dữ liệu chính nó thực sự được lưu trữ trong DataNodes.

- NameNode biết danh sách các khối và vị trí của nó cho bất kỳ tệp tin nào trong HDFS. Với thông tin này NameNode biết làm thế nào để xây dựng các tập tin từ các khối.

- NameNode rất quan trọng đối với HDFS và khi NameNode bị lỗi, cụm HDFS / Hadoop không thể truy cập được và được coi là xuống.

- NameNode thường được cấu hình với rất nhiều bộ nhớ (RAM). Bởi vì các vị trí khối được giúp đỡ trong bộ nhớ chính.

-

Datanode:

- DataNode có trách nhiệm lưu trữ dữ liệu thực tế trong HDFS.

- DataNode còn được gọi là Slave.

- NameNode và DataNode trao đổi data liên tục trong hệ thống.

- Khi một DataNode khởi động nó tự thông báo cho NameNode cùng với danh sách các khối mà nó chịu trách nhiệm.

- Khi DataNode bị lỗi, nó sẽ không ảnh hưởng đến sự sẵn có của dữ liệu hoặc cụm. NameNode sẽ sắp xếp sao chép cho các khối được quản lý bởi DataNode không có sẵn.

- DataNode thường được cấu hình với rất nhiều không gian đĩa cứng. Bởi vì dữ liệu thực tế được lưu trữ trong DataNode.

sudo mkdir -p /usr/local/hadoop_store/hdfs/namenode

sudo mkdir -p /usr/local/hadoop_store/hdfs/datanode

sudo chown -R hduser /usr/local/hadoop_store

Tiếp theo cấu hình file hdfs-site.xml

-

Mở tập tin hdfs-site.xml:

nano hdfs-site.xml

-

Thêm các dòng dưới đây:

<configuration> <property> <name>dfs.replication</name> <value>4</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/usr/local/hadoop_store/hdfs/namenode</value> </property> <property> <name>dfs.datanode.name.dir</name> <value>file:/usr/local/hadoop_store/hdfs/datanode</value> </property> </configuration>- Lưu file hdfs-site.xml

5. Kết thúc

-

Định dạng tập tin hệ thống hadoop bằng cách chạy hdfs namenode. Định dạng để khởi tạo hệ thống tập tin. Thực hiện lệnh dưới đây:

hdfs namenode -format

-

Bắt đầu tạo một single node cluster:

start-dfs.sh

start-yarn.sh

jps

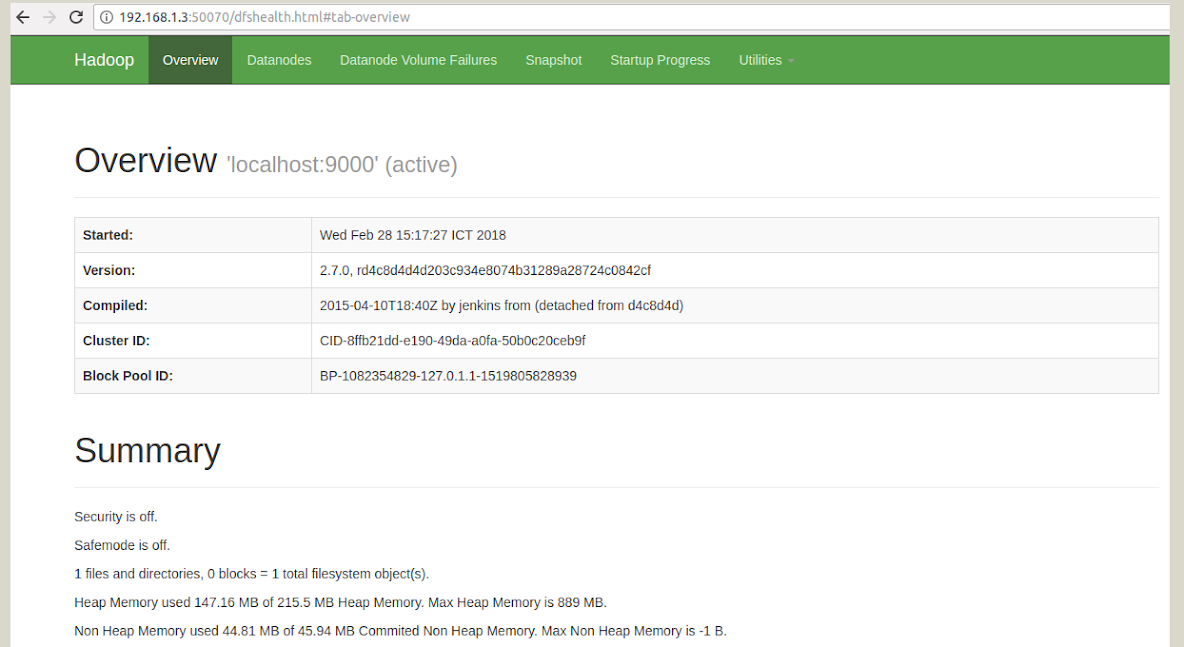

- Mở browser và xem kết quả:

-

https://ip_address:8088 (main cluster)

-

https://ip_address:50070 (see detail information)