BIG DATA TRONG ỨNG DỤNG VÀ CUỘC SỐNG

I. Khái niệm cơ bản về Big Data Vào năm 2001, nhà phân tích Doug Laney của hãng META Group (giờ là công ty nghiên cứu Gartner) đã nói rằng những thách thức và cơ hội nằm trong việc tăng trưởng dữ liệu có thể được mô tả bằng ba chiều “3V”: tăng về số lượng lưu trữ (volume), tăng về tốc ...

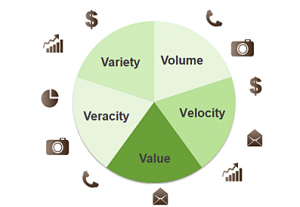

I. Khái niệm cơ bản về Big Data Vào năm 2001, nhà phân tích Doug Laney của hãng META Group (giờ là công ty nghiên cứu Gartner) đã nói rằng những thách thức và cơ hội nằm trong việc tăng trưởng dữ liệu có thể được mô tả bằng ba chiều “3V”: tăng về số lượng lưu trữ (volume), tăng về tốc độ xử lý (velocity) và tăng về chủng loại (variety). Giờ đây, Gartner cùng với nhiều công ty và tổ chức khác trong lĩnh vực công nghệ thông tin tiếp tục sử dụng mô hình “3V” này để định nghĩa nên Big Data. Đến năm 2012, Gartner bổ sung thêm rằng Big Data ngoài ba tính chất trên thì còn phải “cần đến các dạng xử lí mới để giúp đỡ việc đưa ra quyết định, khám phá sâu vào sự vật/sự việc và tối ưu hóa các quy trình làm việc”.

Mô hình “5Vs” – năm tính chất của Big Data

Sau đây là khái niệm mới về Big Data 2014 của Gartner về mô hình “5Vs” – năm tính chất quan trọng nói lên Big Data:

1. Volume (Số lượng lưu trữ) Big Data (“dữ liệu lớn”) là tập hợp dữ liệu có dung lượng lưu trữ vượt mức đảm đương của những ứng dụng và công cụ truyền thống. Kích cỡ của Big Data đang từng ngày tăng lên, và tính đến năm 2012 thì nó có thể nằm trong khoảng vài chục terabyte cho đến nhiều petabyte (1 petabyte = 1024 terabyte) chỉ cho một tập hợp dữ liệu mà thôi.

2. Velocity (Tốc độ xử lý) Dung lượng gia tăng của dữ liệu rất nhanh và tốc độ xử lý đang tiến tới real-time. Các ứng dụng phổ biến trên lĩnh vực Internet, Tài chính, Ngân hàng, Hàng không, Quân sự, Y tế – Sức khỏe ngày hôm nay phần lớn dữ liệu lớn đc xử lý real-time. Công nghệ xử lý dữ liệu lớn ngày một tiên tiến cho phép chúng ta xử lý tức thì trước khi chúng được lưu trữ vào cơ sở dữ liệu.

3. Variety (Đa dạng chủng loại) Hình thức lưu trữ và chủng loại dữ liệu ngày một đa dạng hơn. Trước đây chúng ta hay nói đến dữ liệu có cấu trúc thì ngày nay hơn 80% dữ liệu trên thế giới được sinh ra là phi cấu trúc (tài liệu, blog, hình ảnh, video, voice v.v.). Công nghệ Big Data cho phép chúng ta ngày nay liên kết và phân tích đa dạng chủng loại dữ liệu với nhau như comments/post của một nhóm người dùng nào đó trên Facebook với thông tin video được chia sẻ từ Youtube và Twitter.

4. Veracity (Độ chính xác) Một trong những tính chất phức tạp nhất của BigData là độ chính xác của dữ liệu. Với xu hướng Social Media và Social Network ngày nay và sự gia tăng mạnh mẽ tính tương tác và chia sẻ của người dùng Mobile làm cho bức tranh xác định về độ tin cậy & chính xác của dữ liệu ngày một khó khăn hơn. Bài toán phân tích và loại bỏ dữ liệu thiếu chính xác và nhiễu đang là tính chất quan trọng của BigData.

5. Value (Giá trị thông tin) Giá trị thông tin là tính chất quan trọng nhất của xu hướng công nghệ Big Data. Ở đây doanh nghiệp phải hoạch định được những giá trị thông tin hữu ích của BigData cho vấn đề, bài toán hoặc mô hình hoạt động kinh doanh của mình. Có thể nói việc đầu tiên là phải xác định được tính chất “Value” thì mới nên bắt tay vào BigData.

II. Big Data trong kỹ thuật Chắc hẳn ở đây mọi người được đều nghe về công nghệ đám mây, vậy thì công nghệ đám mây là gì và nó được lưu trữ như thế nào. Bài toán đặt ra là chúng ta cần lưu trữ một khối lượng dữ liệu khổng lồ mà các hệ quản trị dữ liệu thông thường không thể làm được điều đó. Vậy giải pháp lưu trữ một khối lượng dữ liệu lớn như vậy là gì, các nhà khoa học đã đau đầu vì điều này, và họ đã có ý tưởng và xây dụng lên kiến trúc lưu trữ lớn và gọi là BigData. Ở bài viết này mình xin được giới thiệu BigData trong công nghệ đám mây.

1. Tốc độ, khối lượng, tính đa dạng và xác thực của dữ liệu

- Dữ liệu lớn (Big Data) là một tính năng vốn có của công nghệ đám mây và cung cấp cơ hội chưa từng có khi sử dụng cả hai loại cơ sở dữ liệu truyền thống và mạng xã hội, dữ liệu của mạng báo hiệu và xa hơn nữa là dữ liệu đa phương tiện. Các ứng dụng dữ liệu lớn yêu cầu kiến trúc trung tâm dữ liệu và nhiều giải pháp bao gồm các API của nền tảng đám mây để tích hợp với tìm kiếm nâng cao, các giải thuật máy học và các phân tích nâng cao như thị giác máy tính, phân tích phim ảnh và các công cụ phân tích trực quan. Bài viết này nghiên cứu cách sử dụng ngôn ngữ R và các công cụ phổ biến để phân tích dữ liệu lớn và các phương pháp để mở rộng các dịch vụ dữ liệu lớn trong các đám mây. Nó cung cấp một góc nhìn sâu sắc về một dịch vụ dữ liệu lớn cơ bản là quản lý hình ảnh số, trong đó sử dụng các yếu tố cơ bản như tìm kiếm, phân tích và máy học cho dữ liệu không có cấu trúc.

- Sự khác biệt giữa phân tích dữ liệu lớn với phân tích video là về sự đa dạng của dữ liệu xử lý, và khi so sánh các công cụ hỗ trợ tìm kiếm và phân tích, ta có thể thấy rằng sử dụng các phương pháp khai phá dữ liệu hay MapReduce chẳng những có thể phức tạp hơn mà còn mất thời gian lâu hơn rất nhiều so với việc dùng Google BigQuery. Ví dụ Google BigQuery sử dụng tìm kiếm theo chiều dọc để nén và đẩy nhanh quá trình tìm kiếm cho các bộ dữ liệu lớn và phi cấu trúc. Thực tế, trong bài “An Inside Look at Google BigQuery (Tìm hiểu sâu về Google BigQuery)”, Google giải thích, trong 10 giây BigQuery có thể tìm kiếm một đoạn chuỗi trong một bảng dữ liệu có khoảng 35 tỷ dòng và 20TB. Các công cụ dùng chức năng MapReduce mất nhiều thời gian hơn để xử lý nhưng đem lại kết quả tốt hơn.

2. Định nghĩa dữ liệu lớn

- Dữ liệu lớn (Big data) được định nghĩa khái quát là sự thu thập, quản lý và phân tích dữ liệu, những việc đó đã vượt xa dữ liệu cấu trúc tiêu biểu (typical), nó có thể được truy vấn với hệ thống quản lý dữ liệu quan hệ — thường với những tệp phi cấu trúc (unstructured files), video kỹ thuật số, hình ảnh, dữ liệu cảm biến, tệp lưu nhật ký, thực sự bất cứ dữ liệu nào không có trong hồ sơ với các phạm vi tìm kiếm khác. Trong một số ý nghĩa, dữ liệu phi cấu trúc là dữ liệu thú vị, nhưng nó khó tổng hợp vào BI (Business Intelligence) hoặc rút trích ra những kết luận từ nó trừ khi nó có thể tương quan với dữ liệu có cấu trúc.

- Dữ liệu lớn cũng có những nguồn mới, như trong máy tính (vd: các file log nhật ký hay mạng cảm biến), trong thiết bị di động (video, hình ảnh, tin nhắn), và trong các thiết bị máy móc kết nối với nhau (vd như xe, máy bay hoặc các thiết bị giám sát từ xa) nhằm mục đích lên kế hoạch bảo trì kịp thời. Có một cách để làm được việc này là dựa vào đặc tính volume (khối lượng). IBM ước lượng, có 2.5 nhân 10 mũ 18 bytes (2,500,000,000,000,000,000) dữ liệu được tạo ra mỗi ngày.

3. Thiết kế hệ thống dữ liệu lớn

- Những kiến trúc bảo vệ dữ liệu ở quy mô lớn nên bao gồm việc chống mất mát, hư hỏng ngầm, phần mềm độc hại, và ý đồ chỉnh sửa dữ liệu bởi những tội phạm mạng hoặc thông qua chiến tranh mạng. Dữ liệu là tài sản và ngày càng được sử dụng nhiều bởi chính phủ và cũng như trong kinh doanh để đưa ra những quyết định quan trọng, nhưng nếu độ trung thực của dữ liệu không được biết, giá trị của dữ liệu bị giảm hoặc thậm chí bị mất và tệ hơn nữa là: khiến cho việc đưa ra quyết định sai lầm. Chủ đề này nằm ngoại phạm vi thảo luận của bài viết, nhưng rõ ràng sự bảo vệ mất mát và sửa đổi không được biết hoặc hỏng hóc dữ liệu là cần thiết.

- Một cách để hiểu dữ liệu lớn rõ hơn đơn giản là tiếp cận gần hơn những trang web điện toán đám – mây, những trang web này có đủ dữ liệu (thông thường là petabytes) cùng với các công cụ truy vấn (thường là terabytes) cho các ứng dụng sử dụng. Hầu hết chúng ta truy vấn Google hàng ngày, nhưng Google cũng cung cấp BigQuery, BigQuery sử dụng việc lưu trữ và tìm kiếm theo dạng cột phức tạp hơn (đã được thảo luận kỹ hơn thông qua một ví dụ). Những ví dụ nổi tiếng khác như là Facebook (mạng xã hội), Wikipedia (thư viện mở), Internet Archive (nhà giám sát dữ liệu kỹ thuật số), DigitalGlobe (hệ thống thông tin địa lý [GIS]), Microsoft® Virtual Earth (GIS), Google Earth (GIS), và đông đảo những nhà cung cấp dịch vụ dữ liệu lớn mới.

4. Thiết kế hệ thống dữ liệu lớn

- Những kiến trúc bảo vệ dữ liệu ở quy mô lớn nên bao gồm việc chống mất mát, hư hỏng ngầm, phần mềm độc hại, và ý đồ chỉnh sửa dữ liệu bởi những tội phạm mạng hoặc thông qua chiến tranh mạng. Dữ liệu là tài sản và ngày càng được sử dụng nhiều bởi chính phủ và cũng như trong kinh doanh để đưa ra những quyết định quan trọng, nhưng nếu độ trung thực của dữ liệu không được biết, giá trị của dữ liệu bị giảm hoặc thậm chí bị mất và tệ hơn nữa là: khiến cho việc đưa ra quyết định sai lầm. Chủ đề này nằm ngoại phạm vi thảo luận của bài viết, nhưng rõ ràng sự bảo vệ mất mát và sửa đổi không được biết hoặc hỏng hóc dữ liệu là cần thiết.

- Một cách để hiểu dữ liệu lớn rõ hơn đơn giản là tiếp cận gần hơn những trang web điện toán đám mây, những trang web này có đủ dữ liệu (thông thường là petabytes) cùng với các công cụ truy vấn (thường là terabytes) cho các ứng dụng sử dụng. Hầu hết chúng ta truy vấn Google hàng ngày, nhưng Google cũng cung cấp BigQuery, BigQuery sử dụng việc lưu trữ và tìm kiếm theo dạng cột phức tạp hơn (đã được thảo luận kỹ hơn thông qua một ví dụ). Những ví dụ nổi tiếng khác như là Facebook (mạng xã hội), Wikipedia (thư viện mở), Internet Archive (nhà giám sát dữ liệu kỹ thuật số), DigitalGlobe (hệ thống thông tin địa lý [GIS]), Microsoft® Virtual Earth (GIS), Google Earth (GIS), và đông đảo những nhà cung cấp dịch vụ dữ liệu lớn mới.

5. Những ứng dụng dữ liệu lớn

- Phân tích tâm lý thị trường chứng khoán sử dụng Google Trends đã chỉ ra được tương quan tốt cho những tăng giảm chỉ mục theo thời gian, mà có lẽ không đáng ngạc nhiên nhưng những thú vị về tính trọng đại như một ứng dụng dữ liệu lớn. Bài viết “Quantifying Trading Behavior in Financial Markets Using Google Trends (Dự đoán xu hướng thương mại trong thị trường tài chính sử dụng Google Trends)” cung cấp bằng chứng rằng việc sử dụng phân tích tâm lý để kéo dài hay rút ngắn quyết định mua và bán cổ phiếu nắm giữ có thể tốt hơn việc mua và nắm giữ những chiến lược đơn giản và quỹ đầu tư index. Nghiên cứu này có thể được phân tích chi tiết hơn nhưng những kết quả của nó cũng khá thuyết phục. Một nghiên cứu thú vị dự đoán những khả năng xảy ra của một hệ thống cho một lĩnh vực hình thức kinh doanh thực tế.

- Phân loại hình ảnh Picasa từ Google là công cụ hữu ích cho phép người dùng sắp xếp, truy vấn, và nhận dạng khuôn mặt tự động sử dụng những công nghệ thị giác máy tính kết hợp với máy học. Đây là một kết quả tuyệt vời có được từ giá trị của những ứng dụng và dịch vụ trên dữ liệu lớn. Công cụ này làm rõ việc phân tích dữ liệu lớn sẽ đòi hỏi phân tích nâng cao như thị giác máy tính và phương pháp như thị giác máy tính.

- Những hệ thống được khuyến cáo như Pandora (âm nhạc), Netflix (phim ảnh), và Amazon (sách và sản phẩm) dùng dữ liệu khách hàng và nhiều đại lý trong một phương pháp tiếp cận được biết đến là collaborative filtering (phương pháp lọc cộng tác). Dịch vụ dữ liệu lớn này đã là chủ đề của nhiều nghiên cứu tiên tiến trong máy học và khai phá dữ liệu. Rõ ràng là nếu khả năng thực hiện gợi ý tốt thì có thể tăng doanh số bán hàng và sự hài lòng của khách hàng.

- Những phân tích dựa trên khách hàng có thể phân tích tâm lý cho khách hàng của bạn dựa trên dữ liệu mạng xã hội (Facebook và Twitter) khi dữ liệu văn bản này có liên quan đến BI (Business Intelligence) thu thập từ những thông tin giao dịch khách hàng truyền thống. Phân tích tâm lý cho phép một doanh nghiệp biết nhu cầu khách hàng muốn về sản phẩm của họ, sự quan tâm của khách hàng về sản phẩm của họ hay của đối thủ cạnh tranh, những gì khách hàng thích và không thích.

- Dữ liệu được tạo ra từ máy tính có nguồn gốc từ các hệ thống mạng báo hiệu (ví dụ: những cảm biến nhúng trong các hệ thống lớn như giao thông đô thị, đèn giao thông, và cơ sở hạ tầng); dữ liệu giữa các thiết bị máy móc, theo đó mà các thiết bị cảm biến hay dữ liệu đăng nhập từ một máy (thường là trong lĩnh vực này) được truyền đến các máy khác.

- Hệ thống đặt chỗ cho du lịch thì đang được cải thiện bằng cách kết hợp sở thích khách hàng, hậu cần và tiền sử trước khi đưa ra những đề nghị hữu ích, đó luôn là một nhiệm vụ khó khăn.

- Giải trí trên mạng xã hội đang thay đổi các khía cạnh xã hội của việc phát sóng truyền hình và các đoạn phim, nơi mà kỹ thuật số đáp ứng yêu cầu nội dung mọi lúc mọi nơi, nhưng việc chia sẻ kinh nghiệm vẫn phải thông qua mạng xã hội. Mặc dù vậy, điều này giúp khán giả cảm thấy thú vị hơn, cho phép khán giả sáng tạo nội dung, biên kịch, và những nghệ sĩ có thể biết nhiều hơn về khán giả của họ.

- Hệ chuẩn đoán y học bao gồm những hệ thống có sự hỗ trợ của hệ chuyên gia dựa trên luật (gọi là DSSes: Rule-based Expert Decision Support Systems), nhưng với dữ liệu lớn, bằng chứng tồn tại những hệ thống này có thể ra khỏi nghiên cứu và trở thành những người phụ tá y tế chính. III. BigData vào cuộc sống và kinh doanh

1. Trên thế giới

- Nhờ BigData, năm 2013, Amazon đạt doanh thu tới 74 tỷ USD, IBM đạt hơn 16 tỷ USD.

- BigData là nhu cầu đang tăng trưởng lớn đến nỗi từ năm 2010, Software AG, Oracle, IBM, Microsoft, SAP, EMC, HP và Dell đã chi hơn 15 tỷ USD cho các công ty chuyên về quản lý và phân tích dữ liệu.

- Interactions Marketing, một công ty tiếp thị theo hình thức tận dụng ngay chính khách hàng của mình, đã tiến hành kiểm soát dữ liệu lớn bằng cách sử dụng dữ liệu giao dịch điểm bán hàng và dữ liệu thông tin thời tiết khu vực từ nhiều nguồn khác nhau để có được những hiểu biết nhanh nhất về hành vi mua sắm.

- Ngay cả chiến dịch bầu cử của Mỹ cũng có thể được tối ưu hóa bằng việc sử dụng phân tích dữ liệu lớn. Các chuyên gia cho rằng, ông Obama giành chiến thắng trong chiến dịch bầu cử năm 2012 là do khả năng vượt trội của đội ngũ sử dụng khả năng phân tích dữ liệu lớn.

- Gần đây nhất là mùa Worldcup năm ngoái 2014 diễn ra tại Brazin, đội tuyển Đức có một chiến thuật hợp lý, vượt trội cho từng trận đấu với từng đối thủ cũng như cho cả vòng loại? Bí mật này nằm ở công nghệ phân tích big data mà đội tuyển Đức áp dụng từ những năm 2012. Công nghệ này giúp phân tích từng cầu thủ đối phương, đồng thời đưa ra giải pháp tối ưu cho từng cầu thủ trong đội tuyển Đức.

2. Ở việt nam

- FPT cho biết, doanh thu năm 2013 từ S.M.A.C (Mạng xã hội/ Bảo mật), Mobility (Công nghệ di động), Analytics Big Data (Phân tích dữ liệu lớn), Cloud (Điện toán đám mây) đạt 95 tỷ đồng.

- Tổng giám đốc IBM Việt Nam cho biết, Big Data và các giải pháp phân tích kinh doanh đang trở thành trung tâm trong quá trình “chuyển mình” của IBM. Theo ông Tan Jee Toon, mỗi ngày, nền kinh tế thế giới tạo ra 2.5 exabyte dữ liệu (tương đương dữ liệu chứa trên 625 triệu đĩa DVD).

- Big Data và các công nghệ phân tích có khả năng làm thay đổi hoàn toàn bộ mặt của các ngành kinh tế và các nghề nghiệp

- Những mô hình kinh doanh mới dựa trên Big Data đang được hình thành để giúp các tổ chức, doanh nghiệp tận dụng dữ liệu. Đây cũng là xu thế tất yếu trong tương lai không xa với doanh nghiệp Việt Nam.

Kết luận:

- Big Data là thách thức đặt ra cho các tổ chức, doanh nghiệp trong thời đại số hiện nay. Một khi làm chủ được dữ liệu lớn thì họ sẽ có cơ hội thành công lớn hơn trong bối cảnh cạnh tranh ngày nay, thế giới thì sẽ được hưởng lợi hơn từ việc trích xuất thông tin một cách chính xác hơn, hữu ích hơn với chi phí thấp hơn.

- Vẫn còn đó những chỉ trích xoay quanh Big Data, tuy nhiên lĩnh vực này vẫn còn rất mới và chúng ta hãy chờ xem trong tương lai Big Data sẽ tiến hóa như thế nào.

Bài viết sau mình xin nói về Apache Hadoop.

(Còn tiếp… )